最近閱讀了robots.txt協議的全部內容,感覺其作用非常強大。於是自己嘗試這去寫自己的網站:極客志的robots.txt文件。在這過程中整理了一些很實用的知識點,在此跟大家分享一下。

方法/步驟

首先介紹一下功能設置:

User-agent: * 表示允許所有蜘蛛採集;disallow告訴蜘蛛不要抓取某些文件或目錄。如下面代碼將阻止蜘蛛抓取所有的網站文件(/代表跟目錄):User-agent: *Disallow: /Allow: /告訴蜘蛛應該抓取某些文件。Allow和Disallow配合使用,可以告訴蜘蛛某個目錄下,哪些內容可以抓取,哪些內容禁止抓取。如下面代碼將使蜘蛛不抓取wp-admin目錄下其他文件,而只抓取其中ab下的文件:User-agent: *Disallow: /wp-admin/Allow: /wp-admin/ab

下面介紹一下通配符:

$通配符 -User-agent: *Allow: .htm$*通配符 - 告訴蜘蛛匹配任意一段字符。如下面一段代碼將禁止蜘蛛抓取所有htm文件:User-agent: *Disallow: /*.htm

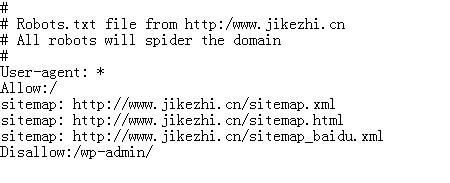

下面以我的網站為例子示範一下,根據協議,極客志網站的robots.txt協議為:

# # Robots.txt file from http:/www.jikezhi.cn # All robots will spider the domain # User-agent: *Allow:/

sitemap: http://www.jikezhi.cn/sitemap.xml

sitemap: http://www.jikezhi.cn/sitemap.html

sitemap:

Disallow:/wp-admin/

寫好之後把文件重命名為:robots.txt 然後上傳到網站的根目錄下面,切記不是主題的根目錄下而是網站的根目錄。

如果你不想自己動手去寫,可以安裝一個wordpress插件:KB Robots.txt 直接在網站後臺插件搜索安裝啟用即可。

注意事項

編寫代碼時要仔細